Sommaire

Croyances étranges du 19ème siècle aujourd’hui réfutées

Il y a deux cents ans, le monde semblait à la fois familier et radicalement différent. Les habitants parlaient déjà des langues proches des actuelles et manifestaient une curiosité comparable à celle des sociétés modernes. Pourtant, ils adhéraient à des croyances qui paraîtraient aujourd’hui particulièrement étranges.

Par exemple, se laver les mains après être allé aux toilettes n’était pas une pratique généralisée, même parmi certains médecins travaillant dans des hôpitaux remplis de malades. L’hygiène, essentielle désormais, pouvait sembler superflue ou inhabituelle à cette époque.

De plus, les médecins transportaient souvent des trousses remplies d’équipements et de traitements qui pourraient surprendre voire troubler : des sangsues encore vivantes ou des flacons de mercure faisaient partie de leurs outils quotidiens. Ces remèdes, aujourd’hui dépassés et dangereux, faisaient partie intégrante de la médecine du 19ème siècle.

Et inutile d’évoquer les biscuits Graham, dont la réputation bien loin de la réalité moderne pouvait décevoir les amateurs curieux de cette époque.

Si les gens du début du 19ème siècle semblaient raisonnables dans certains domaines, leurs convictions révélèrent aussi bien des erreurs majeures qui marquent notre compréhension actuelle de la médecine et des sciences.

Aujourd’hui, le lavage des mains est une pratique fondamentale dans le domaine médical. Pourtant, remontez au début des années 1820 et demandez à un médecin de sortir le savon, et vous risquez de recevoir un regard désapprobateur — voire pire. Au début du XIXe siècle, le lavage des mains était perçu essentiellement comme une habitude culturelle ou religieuse. Certains auteurs et savants anciens, comme le philosophe et médecin du XIIe siècle Moïse Maïmonide, avaient fait le lien entre se laver les mains et une meilleure santé, mais ils étaient une exception dans un univers plutôt insalubre.

Dans cette époque, les hôpitaux étaient souvent considérés comme des lieux où l’on venait pour rapidement mourir ou tomber malade. Les médecins passaient d’une intervention à l’autre sans réelle hygiène, allant parfois d’une autopsie à un accouchement sans se laver entre les deux. Ce n’est qu’aux alentours des années 1840 qu’Ignác Semmelweis, un médecin novateur de l’hôpital général de Vienne en Autriche, analysa les chiffres de mortalité et établit que le simple fait de se laver les mains pouvait sauver des vies. En imposant cette pratique aux médecins sous sa responsabilité, il réduisit drastiquement les infections mortelles dans la maternité de l’hôpital.

Cependant, Semmelweis rencontra une forte opposition. Nombre de ses confrères refusèrent de croire qu’eux-mêmes pouvaient être des vecteurs de maladie, une idée difficile à accepter pour des professionnels de santé. De plus, son caractère quelque peu rude n’a pas facilité l’acceptation de ses découvertes. Tragiquement, face à la résistance et à la pression, Semmelweis fut interné dans un asile.

Si vous avez déjà dégusté un graham cracker, vous savez que ce biscuit sucré et croustillant est un vrai régal. Pourtant, son inventeur serait probablement horrifié par votre gourmandise. Sylvester Graham, prédicateur américain et fervent défenseur d’une hygiène de vie stricte, était un adepte intransigeant du mouvement de tempérance qui gagnait en popularité au 19ème siècle. Ce mouvement ne se limitait pas à l’interdiction de l’alcool : Graham prônait la suppression de tout ce qui pouvait procurer du plaisir. Sa liste noire comprenait notamment la viande, la caféine, le tabac, les matelas mous, les vêtements serrés et les épices.

Selon lui, éviter ces “vices” permettait de maîtriser les pulsions immorales à l’origine, d’après ses convictions, d’affections allant des troubles digestifs aux maladies mentales. Si certaines recommandations de Graham, comme faire de l’exercice régulièrement ou boire beaucoup d’eau, semblaient raisonnables, son biscuit éponyme restait une création étrange. Introduit en 1829, le graham cracker s’inscrivait dans un régime austère composé principalement de fruits, légumes et céréales complètes. Ce biscuit, fait à partir d’une farine de blé intégrale sans ajout de sucre, graisse ou sel, se voulait si fade que personne ne serait tenté par les excès et les péchés.

Cependant, Sylvester Graham n’ayant jamais déposé de brevet, d’autres se sont permis de modifier la recette. La version moderne, que nous connaissons tous aujourd’hui, trouve son origine dans une production sucrée et industrielle lancée par Nabisco en 1898.

La phrénologie, une pseudoscience qui séduisait dangereusement

Au début du XIXe siècle, la phrénologie prétendait révéler l’intelligence, le destin, voire l’âme d’une personne, simplement en observant la forme de son crâne. Issue d’un mélange complexe d’idées développées à la fin du XVIIIe siècle, cette théorie fit immédiatement polémique, si bien que l’empereur François II d’Autriche interdit temporairement les conférences à son sujet.

Pourtant, cette pseudoscience trouva un écho important, donnant naissance à la première association dédiée, la Société phrénologique d’Édimbourg, fondée en 1820. Aux États-Unis, les conférenciers furent bien accueillis et la phrénologie fut perçue comme une discipline intellectuelle et raffinée. Toutefois, cette vogue déclina dans les années 1840, bien que certains de ses concepts perdurèrent jusqu’au XXe siècle.

La phrénologie reposait sur l’idée que différentes régions du cerveau sont responsables de tâches ou capacités spécifiques. Ce principe, si l’on y regarde de près, évoque un précurseur de la neurosciences moderne. Mais là où la théorie bascula dans l’absurde, c’est lorsqu’elle affirmait que plus une faculté est « développée », plus la zone cérébrale correspondante grandirait, jusqu’à repousser littéralement la forme du crâne à cet endroit. Les phrénologues expliquaient que l’interprétation du crâne était plus complexe que la simple détection d’une bosse, mais ces régions cérébrales étaient en fait arbitrairement définies.

Plus inquiétant encore, cette méthode fut trop souvent détournée pour justifier des divisions fondées sur la race, le genre, la classe sociale, la religion ou le jugement de la santé mentale. Cette étrange croyance illustre parfaitement les errements scientifiques du 19ème siècle, mêlant fascination, ignorance et préjugés.

Au début du 19e siècle, beaucoup croyaient encore à la génération spontanée, cette idée selon laquelle la vie organique pourrait naître directement de la matière inorganique. Cette croyance expliquait, par exemple, l’apparition soudaine de larves de mouches dans des matériaux en décomposition. Comment, sinon, expliquer un tel phénomène ?

Même si certains commençaient à douter de cette théorie dans les années 1820, elle restait largement acceptée. Plus tard, en 1859, le scientifique français Félix Pouchet publia des travaux suggérant que de petits êtres comme les bactéries pourraient encore provenir de la génération spontanée. Face à ce débat, l’Académie des sciences française lança un concours avec une récompense de 500 francs pour celui qui mettrait un terme définitif à cette controverse. C’est alors que Louis Pasteur entra en scène.

Pasteur, alors peu connu, mais animé par une vive rivalité scientifique, soutint que les expériences de Pouchet étaient mal contrôlées, laissant passer des bactéries présentes dans l’air dans les contenants testés. Reproduisant ces expériences, Pasteur y ajouta une innovation : il chauffa et étira le col d’une fiole, formant une courbe fine presque hermétique. Résultat, aucun micro-organisme ne se développa dans cette fiole.

Toutefois, certains continuèrent à défendre des variantes de la théorie, comme l’idée que la poussière puisse générer spontanément la vie. Malgré ces réticences, l’Académie déclara finalement Louis Pasteur vainqueur, marquant le déclin de la croyance en la génération spontanée.

Au début du 19e siècle, en cas de problème médical, le médecin pouvait bien sortir son trousseau de lames et de sangsues. À première vue, cette pratique peut sembler médiévale, mais la saignée, dont la technique est déjà ancienne, reposait sur la théorie des humeurs. Selon cette doctrine, le corps humain était gouverné par quatre humeurs : la bile noire, la bile jaune, le sang et le phlegme. Un déséquilibre entre elles était censé provoquer toutes sortes de maladies. Il semblait donc logique de penser que l’extraction de sang pouvait soulager plusieurs affections.

Cette méthode paraissait d’autant plus professionnelle quand le médecin ouvrait son instrumentarium de saignée (ou même le barbier-chirurgien local le faisait). Pourtant, la saignée a certainement causé des décès. George Washington, par exemple, mourut en décembre 1799 après avoir souffert d’un mal de gorge ; on estime que les médecins qui lui ont retiré plus de cinq pintes de sang — à sa demande — ont affaibli dangereusement son état.

Bien que la saignée ait commencé à disparaître vers la fin du 19e siècle, dans les années 1820, elle restait très pratiquée. Une technique populaire consistait à utiliser des sangsues. En effet, cette période marque un véritable engouement pour ces petits suceurs de sang. Par exemple, à l’hôpital St. Thomas de Londres, on employa environ 50 000 sangsues en 1822 seulement — un bond considérable par rapport aux années précédentes. Plutôt que de poser la sangsue au hasard, on utilisait un tube pour la guider vers la zone précise du corps à traiter.

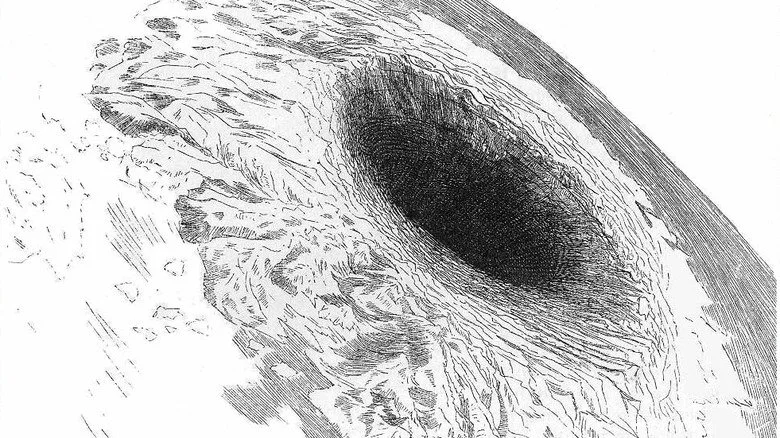

Si vous êtes géologue ou avez simplement feuilleté un manuel de sciences de la Terre, vous savez sans doute que notre planète est globalement solide. Les générations de recherches ont clairement démontré que la Terre n’est en aucun cas creuse, mais plutôt constituée de roches solides et de magma semi-liquide. Pourtant, il y a 200 ans, qu’on soit scientifique ou un certain type d’orateur bruyant, cette certitude n’était pas aussi évidente.

À cette époque, la théorie d’une Terre creuse, abritant des merveilles inconnues, semblait presque plausible. En réalité, cette idée remonte à l’Antiquité, avec des penseurs comme l’astronome du XVIIe siècle Edmund Halley qui envisageait la Terre comme une série de couches imbriquées, susceptibles de perturber les boussoles et pourquoi pas, d’abriter des formes de vie.

L’hypothèse prit un nouvel élan dans les années 1820 grâce à l’Américain John Cleves Symmes Jr. Celui-ci affirma haut et fort que les deux pôles de la planète renfermaient des entrées vers cet univers intérieur caché. Ces ouvertures, surnommées les « trous de Symmes », captivèrent l’imaginaire populaire, sans toutefois gagner la reconnaissance scientifique. Symmes entreprit une tournée de conférences et séduisit quelques adeptes influents, parmi lesquels l’ancien président John Quincy Adams. Cependant, il ne réussit jamais à obtenir les financements nécessaires pour une expédition polaire.

John Cleves Symmes mourut en 1829 dans l’Ohio. Son fils, Americus, fit ériger un monument sur sa tombe, ornée d’un globe creux, symbolisant la persistance de cette croyance singulière.

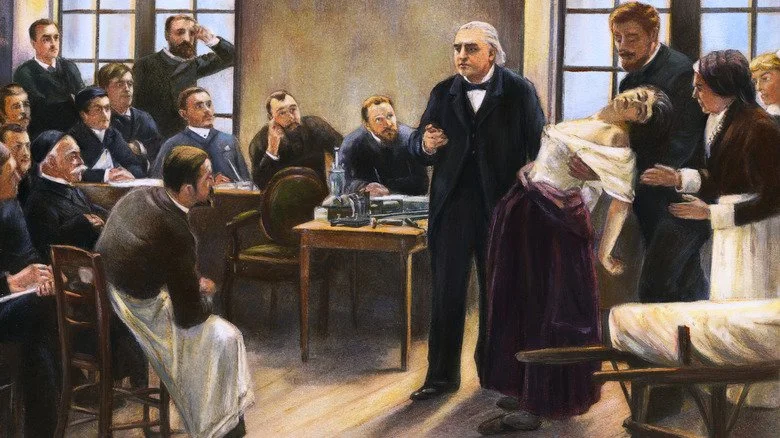

Pendant une grande partie de l’histoire, être une femme nécessitant des soins médicaux était une situation particulièrement difficile. L’un des exemples les plus frappants est la notion d’« hystérie ». Cette idée, courante au début du 19ème siècle, remontait en réalité à plusieurs générations auparavant. Les anciens Grecs pensaient par exemple que l’utérus pouvait se déplacer à l’intérieur du corps et provoquer toutes sortes de troubles.

Pour empêcher cet organe supposément errant d’étouffer ou d’écraser les autres organes, on avait recours à des méthodes étonnantes : placer des odeurs offensantes près de la tête pour faire fuir « l’utérus » et des parfums agréables à l’extrémité opposée du corps. Cette théorie fut contestée par certains, comme le médecin antique Galien, qui rejetait le déplacement de l’utérus mais admettait d’autres idées tout aussi surprenantes, comme la présence d’« esprits animaux » censés animer la pensée.

Malgré les progrès de la médecine, les médecins du début du 19ème siècle continuaient à attribuer de nombreux troubles féminins à l’hystérie. Certains, tels que Philippe Pinel, défendaient une approche plus humaine envers les patientes, bien que cette bienveillance se teintait souvent de paternalisme. Cette étiquette médicale servait surtout à isoler les femmes décrites comme trop émotionnelles, irrationnelles ou atteintes par cet « utérus encombrant », en les excluant de certains emplois et domaines sociaux.

Ce qui est sans doute le plus étonnant, c’est que le diagnostic d’hystérie n’a été officiellement abandonné par la plupart des sociétés professionnelles de psychologie qu’à partir des années 1980.

Qu’est-ce qui cause exactement les maladies ? Si vous posiez cette question dans les premières décennies des années 1800, il y a peu de chances que l’on vous parle alors de la théorie des germes. Imaginez : pour ces médecins érudits, l’idée que de minuscules organismes invisibles puissent pénétrer dans le corps humain et provoquer des maladies semblait absurde. À leurs yeux, c’était plutôt « l’air vicié » qui rendait malade. Ce « mauvais air », bien que rarement nommé ainsi, était désigné par un terme plus savant : le « miasme ».

La théorie du miasme, aujourd’hui célèbre pour avoir été complètement infirmée, affirmait que les maladies ne résultaient pas de germes, mais de vapeurs aéroportées considérées comme nocives. Par exemple, certains observateurs notaient que les cas de choléra à Londres se concentraient dans les quartiers les plus bas, là où ces vapeurs dangereuses avaient tendance à s’accumuler. En réalité, la véritable cause était une eau contaminée et des conditions d’hygiène publique déplorables.

Parmi les pionniers qui commencèrent à remettre en question cette croyance, John Snow se démarqua. Ce médecin et chercheur britannique cartographia les foyers de choléra dans les zones défavorisées de Londres, suggérant très tôt que l’eau contaminée jouait un rôle bien plus important dans la propagation des maladies que les mystérieux miasmes. Pourtant, à sa mort en 1858, l’idée que les microbes étaient responsables des infections restait encore largement rejetée par la communauté scientifique.

Au début du XIXe siècle, le mesmerisme suscitait de vives controverses. Cette pratique, précurseur de l’hypnotisme moderne, prit son essor grâce au médecin autrichien Franz Anton Mesmer, qui prétendait que le corps humain était traversé par un fluide magnétique dont le déséquilibre causait diverses maladies.

Contrairement aux méthodes médicales traditionnelles telles que la saignée, Mesmer proposait de rétablir la santé en manipulant ce champ magnétique mystérieux, offrant ainsi une approche quasi mystique du traitement. Son succès fut particulièrement notable auprès de l’aristocratie, où des dames riches et souvent oisives se pressaient dans ses salons pour bénéficier de ses soins.

Cependant, le scepticisme ne tarda pas à émerger. Les réactions spectaculaires observées chez les patientes – convulsions, évanouissements, comportements jugés indécents à l’époque – alimentèrent les critiques. Malgré cela, le mesmerisme persista, en partie grâce à son aura provocante et presque rebelle.

La pratique traversa l’Atlantique dans les années 1820, où elle connut un regain d’intérêt aux États-Unis plusieurs décennies plus tard, portée par des médecins ou, selon leurs détracteurs, des charlatans. Ils multiplièrent alors publications et conférences, contribuant à pérenniser cette croyance étrange du 19ème siècle.

Le mercure, un élément indispensable dans la trousse du médecin

Il est aujourd’hui largement admis que le mercure est une substance toxique, capable d’endommager gravement le système nerveux, la peau, les yeux et les reins. Pourtant, il y a 200 ans, cette métal liquide faisait partie intégrante des traitements médicaux. Au début du XIXe siècle, les médecins administraient couramment du mercure sous diverses formes : solutions topiques, pilules, voire par inhalation de vapeurs, souvent au péril de la santé des patients.

Cette pratique persistait même à l’époque victorienne et ne disparut vraiment qu’au XXe siècle. Parmi les cas célèbres, on pense notamment au président Abraham Lincoln, qui aurait consommé régulièrement des pilules connues sous le nom de « Blue Mass », contenant du mercure. Ces pilules étaient prescrites pour lutter contre la mélancolie, une forme de dépression dont Lincoln aurait souffert toute sa vie.

Cependant, la prise de mercure s’avérait souvent problématique : Lincoln cessa ce traitement peu après son accession à la présidence, ayant constaté que ce médicament pouvait entraîner des troubles émotionnels au lieu de les guérir. À cette époque, le mercure était utilisé pour traiter des affections variées comme les maladies mentales, la fièvre jaune et la syphilis.

Il est donc plausible que les effets secondaires du mercure – accès de colère soudaine, symptômes neurologiques – aient également affecté d’autres patients avant Lincoln, illustrant les limites des connaissances médicales de cette époque.

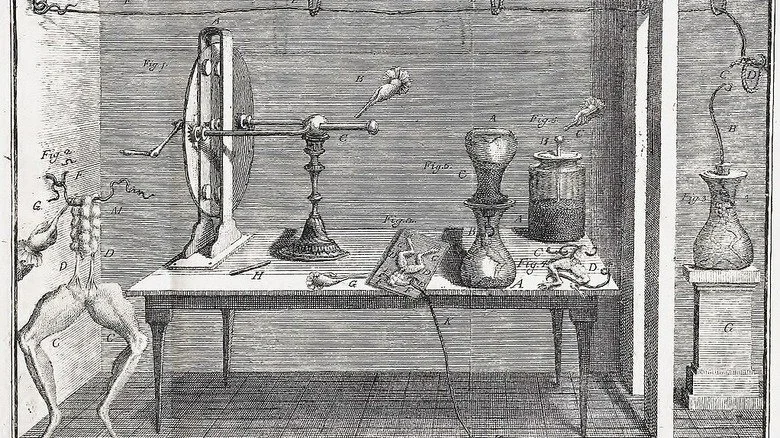

L’image du monstre de Frankenstein renaissant sur une table au milieu d’une tempête électrique est dramatique, mais s’appuie sur un fond de vérité. Pas en tant que copie conforme, mais suffisamment pour intriguer sur les expériences menées par les scientifiques des années 1820. À cette époque, plusieurs avaient déjà testé des décharges électriques légères qui provoquaient des convulsions étranges, presque vivantes, sur des cadavres, y compris chez l’humain. Ce phénomène, appelé galvanisme, porte le nom de l’anatomiste Luigi Galvani, qui fut l’un des premiers à expérimenter avec l’électricité sur des grenouilles mortes dans les années 1780.

Ces expériences hybrides, entre science et spectacle, mêlaient étincelles et détonations pour fasciner leurs spectateurs. L’écrivaine Mary Shelley en avait certainement entendu parler, bien qu’elle ne le mentionne explicitement qu’en préface de l’édition de 1831 de son roman Frankenstein.

Si la plupart s’intéressaient surtout à comprendre le fonctionnement des muscles sous l’effet de l’électricité, certains imaginaient que le galvanisme pourrait, peut-être, ramener un mort à la vie. Par exemple, le chimiste écossais Alexander Ure tenta cette expérience en 1818, sans succès au niveau de la réanimation. Parallèlement, on explorait d’autres mystères : des chercheurs se demandaient si les rétines des défunts pouvaient conserver des images.

Dans un registre proche, le scientifique danois Hans Christian Ørsted fit une découverte majeure en observant que le passage du courant électrique dans une pile pouvait influer sur l’aiguille d’une boussole. Cette observation, publiée en 1820, ouvrit la voie à l’étude de l’électromagnétisme, démontrant que ce phénomène électrique et magnétique était véritablement tangible.